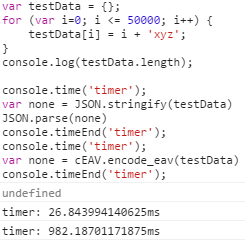

Ein Beweis der These "JSON wäre langsamer" würde mich sehr interessieren, immerhin versuchst Du, gegen eine native Browserimplementation anzustinken!

Du stänkerst.

Moment! Immerhin habe ich zunächst einmal bewiesen, dass JSON im Client dramatisch schneller ist, als Deine Implementation. Es gibt noch weitere Gründe, JSON den Vorzug zu geben, aber die lassen wir an der Stelle mal beseite. Wir bleiben rein bei der Performance...

Betrachte bitteschön auch die De-Serialisierung serverseitig, genau da liegt nämlich der Performanceunterschied.

OK! Im Gegensatz zum JavaScript kann ich hier leider keine Messung vornehmen, außer Du stellst den fraglichen Code zur Verfügung?!

Unterstellen wir mal, Du hast Recht und Deine Implementatin ist schneller: auch dann gilt die Eingangsfrage, welch immense Daten Du deserialiseren musst, um einen messbaren Unterschied zu erhalten.

Ohne Deinen Code zu kennen, habe ich aber auch serverseitig so meine Zweifel, ob Deine Implementation wirklich schneller sein soll, als JSON. Wenn wir von einer gewöhnlichen Perl-Installation ausgehen, dann wird intern ein C-Kompilat(JSON::XS) verwendet. Es fällt mir schwer zu glauben, dass Dein Perl-Code dagegen anstinken kann.

Wenn ich damit falsch liegen sollte, freue ich mich auf Deine nachvollziehbare Beweisführung.

Gunnar Bittersmann

Gunnar Bittersmann

Felix Riesterer

Felix Riesterer

Felix Riesterer

Felix Riesterer

Matthias Apsel

Matthias Apsel

Gunnar Bittersmann

Gunnar Bittersmann

Matthias Apsel

Matthias Apsel